Podemos decir que a veces los pequeños cambios pueden provocar resultados muy favorables sobre todo en el desempeño de alguna tarea manual o automatizada y fiel a mi afiliación a la cultura pop :) recordé el filme del efecto mariposa.

Pues bien empezamos a hacer pruebas con Apache Spark ya no con archivos de texto, sino con la conexión a base de datos que en pasados artículos ya habíamos platicado pero ahora con mediciones en los tiempos.

Las primeras comparaciones fueron muy decepcionantes ya que usando la conexión a la base de datos de Oracle la realizaba un poco más de 10 veces más lento que consultando el mismo número de registros con un archivo de texto, la primer prueba muy básica y sencilla: un archivo de casi 18 millones de registros (17,953,202) consultados desde una tabla de una base de datos de Oracle contra el mismo número de renglones de un archivo de texto que realizará dicho conteo usando instrucciones dplyr.

Sin embargo nuevamente el buen Edgar se fijó en el código que había investigado y le llamó la atención un atributo en FALSE, el de memory.

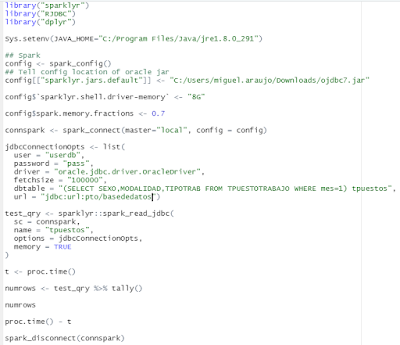

test_qry <- sparklyr::spark_read_jdbc(

sc = connspark,

name = "tpuestos",

options = jdbcConnectionOpts,

memory = TRUE

)

Por lo que ahora al hacer la prueba los resultados ya son muy similares en los tiempos porque de acuerdo a lo investigado Apache Spark puede utilizar todos los recursos del equipo donde se ejecuta (memoria en disco y RAM) inclusive los servicios a los que se conecta como el ancho de banda de la red.

Dejo aquí código de ambos scripts de R y sus resultados.

Archivo de texto (CSV)

Podemos observar que para la carga del archivo CSV se realizó casi en 56 segundos mientras que la consulta la realizó en menos de 1 segundo (0.81)

En este código no viene el atributo memory por lo que por omisión queda en TRUE.

Base de datos de Oracle

Podemos observar que para la carga de la tabla en el dataset de Apache Spark se realizó casi en 40 segundos mientras que la consulta la realizó al igual que el archivo csv en menos de 1 segundo (0.7)

Una de las cosas que notó el compañero era la ausencia de una de las pestañas del monitor web de Spark (Storage) y fue como se dedujo que había que cambiar dicho atributo.

Comentarios

Publicar un comentario